Unternehmenssicherheit muss KI-Systeme schützen

Welche Risiken birgt der Einsatz von Künstlicher Intelligenz für die Unternehmenssicherheit und was ist für den Schutz von Unternehmen zu beachten?

Die neuen Modelle der Künstlichen Intelligenz (KI) eröffnen Unternehmen viele Chancen, Geschäftsprozesse effizienter zu gestalten, haben allerdings auch gewisse Risiken und Auswirkungen auf die Unternehmenssicherheit. Das Sprachsynthese-Tool „ChatGPT“ begeistert seit Ende 2022 die interessierte Öffentlichkeit – ruft aber auch Bedenken hervor. Die aktuelle Debatte um die künstlich erzeugten Texte verdeutlicht, dass jeder KI-Einsatz sowohl mit Vorteilen als auch Gefahren verbunden ist. Bei Recherchen, dem Verfassen von Mailentwürfen oder der Beantwortung von Standard-Kundenanfragen kann der KI-Dienst viel Zeit ersparen. Andererseits lassen sich manche Schüler oder Studierende ihre Hausarbeiten vom KI-Onlinedienst verfassen. Das sabotiert im Ausbildungs- und Forschungskontext das eigentliche Anliegen, sich selbständig Wissen anzueignen und daraus eigene Positionen zu entwickeln. Noch dazu lässt sich auf den ersten Blick der maschinelle Ursprung der Texte kaum erkennen.

KI-Systeme haben Auswirkungen auf die Unternehmenssicherheit

Im Unternehmenskontext ergeben sich durch unbedachten Einsatz von KI-Systemen mögliche Auswirkungen, denen zum Unternehmensschutz jeweils organisatorisch, prozessual, kaufmännisch-rechtlich und technisch begegnet werden muss:

Beispiel 1: Zur Automatisierung der Kundenkommunikation können Unternehmen KI-basierte Chatbots einsetzen. Diese könnten sich im Laufe längerer Konversationen allerdings diskriminierend äußern oder thematisch abschweifen, da sie eventuell mit Konversationen aus sozialen Medien trainiert wurden, die pauschalierende oder diffamierende Verläufe genommen haben, wie einst im Fall des Microsoft-Chatbots Tay. Denkbar ist auch, dass der Chatbot mutwillig von Dritten manipuliert wird, um Kunden zu verärgern. Vor dem Einsatz sollten etwa ausführliche Testreihen mit realistischen Kundeninputs stehen, um die Reputation des Unternehmens zu schützen und Klagen angegriffener Kunden zu vermeiden. Updates der KI-Zulieferer müssen jeweils erneut geprüft und freigegeben werden. Schließlich sollten Chatbots bei Wissenslücken nicht in repetitive Endlosschleifen abgleiten, sondern rechtzeitig menschliche Ansprechpartner einschalten. Hilfreich ist es, vor dem Einsatz des Chatbots vergleichbare Unternehmen oder Industrie- und Handelskammern nach ihren Erfahrungen mit Chatbots zu befragen.

Missbrauch verhindern

Beispiel 2: KI-Systeme können das Monitoring großer Mengen an Überwachungskamera-Videomaterial unterstützen. Für die Mitarbeitenden in den Sicherheitszentralen ist die permanente Auswertung aller Kamerabilder nicht durchführbar. KI-Modelle können die digitalen Videostreams jedoch in Echtzeit analysieren. Dem Personal werden in Sekundenschnelle nur noch als relevant erkannte Anomalitäten zur gezielten Auswertung angezeigt. Jedoch könnten in unerwarteten Situationen, für die das KI-Modell nicht trainiert wurde, Falschalarme ausgelöst werden oder, noch schlimmer, notwendige Warnungen ausbleiben – Fehleinschätzungen, die bei menschlicher Beurteilung vermieden worden wären.

Hintergrund: KI lernt in der Regel nicht wie ein Mensch, also prinzipbasiert, sondern symptombasiert. Die von Maschinen erkannten Unterscheidungsmerkmale zwischen „normal“ und „auffällig/potenziell gefährlich“ entsprechen nicht zwingend den von Menschen angewandten. Etwa könnten unterschiedliche Pixel-Auflösungen oder übersehene Copyright-Vermerke, Uhrzeiteinblendungen oder Logos im Trainingsbildmaterial vom KI-Modell fälschlicherweise als inhaltlich klassifizierend interpretiert werden und zu falschen Entscheidungen führen. Auch hier ist denkbar, dass die Trainingsdaten von Hackern manipuliert werden, um gezielte Fehlentscheidungen des Systems zu forcieren. Zudem liefern KI-Modelle bisher nur im Ausnahmefall Begründungen für ihre Entscheidungen, was etwa im Haftungsfall eine rechtliche Würdigung erschwert. Hier sind ausführliche Testreihen vor Ort und detaillierte Audits der Trainingsdaten beim KI-Anbieter angeraten.

Im Whitepaper der Plattform Lernende Systeme „KI-Systeme schützen, Missbrauch verhindern“ sind weitere Szenarien und Maßnahmen zur Unterstützung der Unternehmenssicherheit aufgeführt.

Immense Schäden durch gehackte KI-Systeme

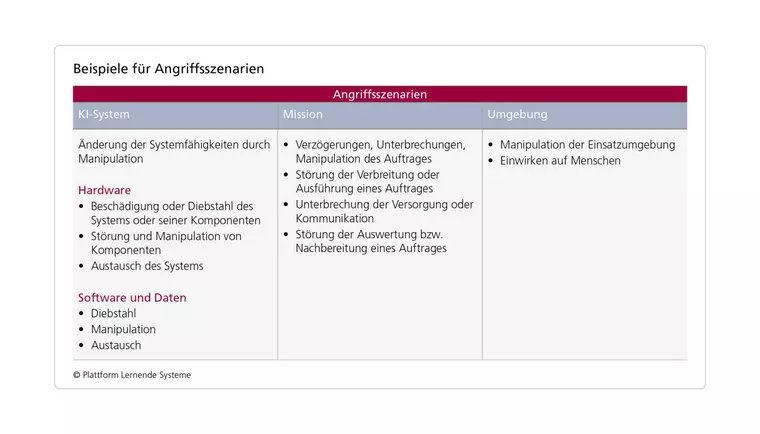

KI-Modelle sind aus Sicht der Unternehmens-IT letztlich Computersysteme, die den typischen Angriffsszenarien ausgesetzt sind. Sie müssen bezüglich ihrer Verfügbarkeit, Integrität, Authentizität und Vertraulichkeit mindestens den technischen und organisatorischen Schutzanforderungen nach dem Stand der Technik genügen. Kaum eine böswillige IT-Manipulation durch externe Hacker oder Innentäter kann künftig ähnlich großen Schaden in Unternehmen und Behörden anrichten wie ein gehacktes KI-System. KI wird häufig zur Automatisierung unternehmensweiter Kernprozesse eingesetzt. Wird das Verhalten des KI-Systems missbräuchlich verändert, kann dies zum Schaden der Organisation gereichen: oft lange Zeit unbemerkt, aber potenziell höchst effektiv. Von der Zutrittskontrolle zum hauseigenen Rechenzentrum bis zur Verschlüsselung aller KI-Daten gibt es eine Vielzahl von Sicherheitsmaßnahmen, die Organisationen beachten sollten oder müssen. Dies gilt insbesondere, wenn sie etwa in den Regelungsbereich des IT-Sicherheitsgesetzes 2.0, der europäischen NIS2-Richtlinie oder branchenspezifischer Vorschriften wie etwa der MARisk für den Finanzsektor fallen. Hilfestellung zum Einstieg in systematische IT-Sicherheitskonzepte bieten hier etwa das für kleine und mittlere Unternehmen konzipierte „CISIS12“-Modell, Informationen zum Stand der Technik der IT-Sicherheit oder das IT-Grundschutzkompendium des Bundesamts für Sicherheit in der Informationstechnik.

Neben diesen augenfälligen Beispielen für Unternehmensrisiken im Zusammenhang mit KI gibt es eine Vielzahl weiterer Herausforderungen, die durch den Einsatz von KI entstehen. So muss etwa bei der Verarbeitung personenbezogener Trainings- und Vorgangsdaten der Konflikt zwischen den Archivierungs- und Datenlöschungsinteressen datenschutzrechtlich einwandfrei aufgelöst werden.

Diese Überlegungen sollten jedoch nicht dazu führen, dass Erprobung und Einsatz von KI als produktivitäts- und qualitätssteigerndes Instrument vermieden werden. Ihr potenzieller Nutzen übersteigt bei adäquatem Schutz vor unbefugter Manipulation durch Cyberkriminelle und bei Beachtung von Entscheidungstransparenz, Diskriminierungsfreiheit und Datenschutz die Risiken erheblich. Dies gilt auch im Bereich der Unternehmenssicherheit – gerade dann, wenn der Betrieb hochautomatisiert ablaufen soll.

Über die Plattform Lernende Systeme

Die Plattform Lernende Systeme ist ein Netzwerk von Experten zum Thema KI. Sie bündelt vorhandenes Fachwissen und fördert als unabhängiger Makler den interdisziplinären Austausch und gesellschaftlichen Dialog. Die knapp 200 Mitglieder aus Wissenschaft, Wirtschaft und Gesellschaft entwickeln in Arbeitsgruppen Positionen zu Chancen und Herausforderungen von KI und benennen Handlungsoptionen für ihre verantwortliche Gestaltung. Damit unterstützen sie den Weg Deutschlands zu einem führenden Anbieter von vertrauenswürdiger KI sowie den Einsatz der Schlüsseltechnologie in Wirtschaft und Gesellschaft. Die Plattform Lernende Systeme wurde 2017 vom Bundesministerium für Bildung und Forschung (BMBF) auf Anregung des Hightech-Forums und Acatech – Deutsche Akademie der Technikwissenschaften gegründet und wird von einem Lenkungskreis gesteuert. Die Leitung der Plattform liegt bei Bundesministerin Bettina Stark-Watzinger (BMBF) und Jan Wörner (Acatech).

Peter Rost, Director Business Development bei der Secunet Security Networks AG und Mitglied der Arbeitsgruppe IT-Sicherheit, Privacy, Recht und Ethik der Plattform Lernende Systeme

Passend zu diesem Artikel

Die Bandbreite an Polykrisen im globalen Maßstab nimmt zu. Wie können sich Unternehmen mithilfe ihres Risikomanagements darauf vorbereiten?

Chancen und Bedenken beim Einsatz von generativer Künstlicher Intelligenz (KI) in der Customer Experience.

KI-Algorithmen sind fester Bestandteil der digitalen Transformation und Prozessoptimierung in Unternehmen geworden.